Seedance 1.0: วิดีโอ AI ที่คิดเหมือนผู้กำกับ

AI video model ส่วนใหญ่แค่เรนเดอร์เฟรมให้ครบตาม prompt แต่ Seedance 1.0 ไปไกลกว่านั้น มัน “ออกแบบกล้อง” เหมือนผู้กำกับที่อ่านบทแล้วรู้ว่าต้องแพนซ้ายเมื่อไหร่ ต้องซูมเข้าเมื่อไร เพื่อพาอารมณ์ของฉากให้ไหลไปต่อ

นี่ไม่ใช่แค่ T2V (Text-to-Video) หรือ I2V (Image-to-Video) ทั่วไป แต่มันคือการสังเคราะห์ “multi-shot cinematic reasoning” ให้ภาพหลายช็อตเรียงต่อกันอย่างลื่นไหล ทั้งมุมกล้องและแสงเงาอยู่ในทิศเดียวกันราวกับมี DOP มืออาชีพควบคุมอยู่เบื้องหลัง

ระบบภายในที่ทำให้มันต่าง

Seedance ใช้สถาปัตยกรรมแบบ 3-phase:

- Story Encoder: แปลงข้อความหรือภาพให้กลายเป็น block ลำดับเหตุการณ์

- Camera Plan Generator: วาง movement shot ต่อ shot (ซูม, pan, dolly, steadycam) ตามคำสั่ง

- Frame Synthesis Engine: ประมวลผลเป็นวิดีโอ 1080p พร้อมการคุม motion blur, timing, และ color tone

แต่ละส่วนไม่เพียงเข้าใจคำสั่งเท่านั้น มันยังรู้ว่า “อะไรควรมาก่อน–หลัง” เช่น กล้องควรดึงออก (pull back) ก่อนตัวละครหาย หรือควร cut-in shot มา close-up เมื่อตัวละครแสดงสีหน้าเปลี่ยน

เปรียบเทียบกับคู่แข่ง

Sora เน้นความสมจริง

Runway เด่นที่ความเร็ว

Kling มาทางขยับภาพแบบ action-heavy

แต่ Seedance เลือกจุดยืนที่ชัดกว่า คือ “logic ของการเล่าเรื่อง” และ “การเคลื่อนกล้องหลายช็อตที่เชื่อมต่อกันได้จริง” ถ้าเทียบง่าย ๆ มันไม่ใช่แค่ animator แต่คือ editor ที่ตัดต่อเก่ง และจำอารมณ์ของช็อตก่อนหน้าได้

Seedance บนกระดาน Arena จริง

ในโลกของโมเดล AI ไม่ใช่แค่ใครทำได้ แต่ใคร “ทำได้ดีในสนามจริง” ต่างหากที่นับแต้ม

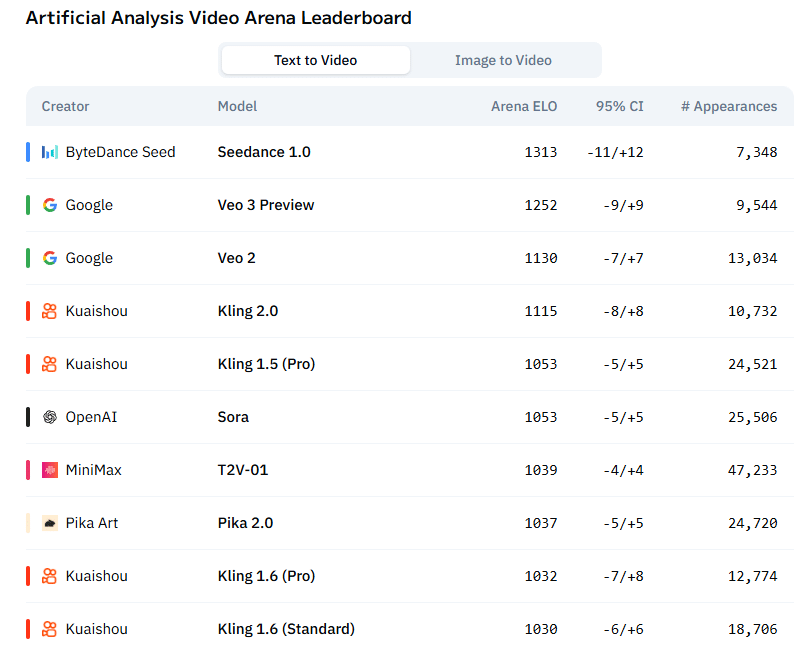

Seedance นำอันดับด้วย ELO 1313 ทิ้งห่าง Veo 3 จาก Google และ Sora จาก OpenAI อย่างมีนัยยะ โดยมีช่วงความเชื่อมั่น (95% CI) ค่อนข้างนิ่งแค่ ±11–12

จุดที่น่าสนใจคือแม้ จำนวนการปรากฏตัว (Appearances) ของ Seedance ยังน้อยกว่า Sora หรือ MiniMax T2V-01 แต่คะแนน Arena กลับทิ้งขาด แปลว่าคุณภาพเฉลี่ยในแต่ละ match ทำผลงานได้ “เด็ดขาด” มากกว่าคู่แข่งหลายเท่า

ใช้ในงานจริงได้แค่ไหน?

ในรันเดียวบน L20 GPU, Seedance ใช้เวลาแค่ ~41 วินาที เพื่อสร้างวิดีโอ 5 วินาที ที่มีคุณภาพระดับเอาไป post โปรโมตได้เลย

มันไม่ต้องอาศัย fine-tuning เยอะ และผลลัพธ์ไม่ต้องเกลี่ยต่อ เพราะ motion stabilizer ในโมเดลช่วยให้ขอบภาพนิ่ง สไตล์ไม่กระตุก และฉากไม่หลุดออกจากบริบท

อนาคตของโมเดลแบบนี้

Seedance อาจเป็น prototype ของคลื่นลูกใหม่: AI-Directed Storyboard Generator ที่ไม่ได้แค่เรนเดอร์ภาพ แต่รู้ลำดับภาพที่ควรเกิด

ถ้า GPT คือ writer, Seedance ก็อาจเป็น director คนแรกของโลกที่เป็นโมเดล ไม่ต้องมี sense of humor ไม่ต้องเข้าใจมนุษย์แบบลึก แต่มันจำได้ว่า “ฉากนี้ต้องคัทมาตรงไหน” และ “ซูมเข้าแค่ไหนถึงจะยังอยู่ในฉากเดียวกัน”

Leave a Reply